隨著人工智能技術(shù)的飛速發(fā)展,AI大模型(如GPT、BERT等)已成為推動(dòng)創(chuàng)新的核心驅(qū)動(dòng)力。AI大模型的網(wǎng)絡(luò)搭建涉及復(fù)雜的硬件、軟件和網(wǎng)絡(luò)架構(gòu)設(shè)計(jì),而相應(yīng)的網(wǎng)絡(luò)技術(shù)服務(wù)則是確保模型高效運(yùn)行和拓展的關(guān)鍵。本文將系統(tǒng)介紹AI大模型網(wǎng)絡(luò)搭建的步驟,并探討網(wǎng)絡(luò)技術(shù)服務(wù)的核心內(nèi)容。

一、AI大模型網(wǎng)絡(luò)搭建的關(guān)鍵步驟

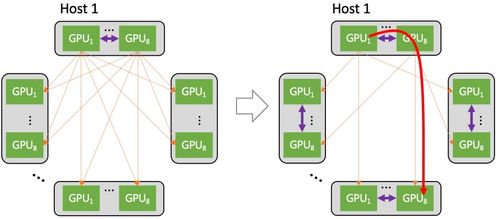

- 硬件基礎(chǔ)設(shè)施規(guī)劃:AI大模型需要強(qiáng)大的計(jì)算資源,通常采用GPU集群(如NVIDIA A100或H100)來(lái)支持訓(xùn)練和推理。網(wǎng)絡(luò)搭建首先需設(shè)計(jì)高速互聯(lián)架構(gòu),例如使用InfiniBand或RoCE(RDMA over Converged Ethernet)技術(shù),以減少通信延遲并提升數(shù)據(jù)傳輸效率。需確保充足的存儲(chǔ)系統(tǒng),如分布式文件系統(tǒng)或?qū)ο蟠鎯?chǔ),以處理海量數(shù)據(jù)集和模型參數(shù)。

- 軟件環(huán)境配置:搭建網(wǎng)絡(luò)需部署專(zhuān)用軟件棧,包括深度學(xué)習(xí)框架(如TensorFlow、PyTorch)和分布式訓(xùn)練工具(如Horovod或NCCL)。容器化技術(shù)(如Docker和Kubernetes)常用于管理資源,確保模型可伸縮部署。需設(shè)置監(jiān)控和日志系統(tǒng),實(shí)時(shí)跟蹤網(wǎng)絡(luò)性能和模型狀態(tài)。

- 網(wǎng)絡(luò)架構(gòu)設(shè)計(jì):對(duì)于大規(guī)模模型,網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)至關(guān)重要。常見(jiàn)的架構(gòu)包括星型、環(huán)型或混合拓?fù)洌詢?yōu)化節(jié)點(diǎn)間通信。安全措施如防火墻、VPN和加密協(xié)議必須集成,防止數(shù)據(jù)泄露和攻擊。網(wǎng)絡(luò)帶寬和延遲需通過(guò)負(fù)載均衡和流量管理工具進(jìn)行優(yōu)化,確保訓(xùn)練過(guò)程的穩(wěn)定性。

- 數(shù)據(jù)管道與預(yù)處理:搭建網(wǎng)絡(luò)時(shí),需構(gòu)建高效的數(shù)據(jù)管道,支持?jǐn)?shù)據(jù)的采集、清洗和預(yù)處理。這可能涉及與云服務(wù)(如AWS或Azure)集成,實(shí)現(xiàn)數(shù)據(jù)流的無(wú)縫對(duì)接。數(shù)據(jù)隱私和合規(guī)性需通過(guò)匿名化或聯(lián)邦學(xué)習(xí)技術(shù)來(lái)處理。

二、網(wǎng)絡(luò)技術(shù)服務(wù)在AI大模型中的應(yīng)用

網(wǎng)絡(luò)技術(shù)服務(wù)是AI大模型生命周期中的支撐環(huán)節(jié),主要包括:

- 部署與運(yùn)維服務(wù):提供模型的云端或本地部署,包括自動(dòng)化腳本、持續(xù)集成/持續(xù)部署(CI/CD)流程,以及7x24監(jiān)控服務(wù),確保高可用性和快速故障恢復(fù)。

- 性能優(yōu)化服務(wù):通過(guò)網(wǎng)絡(luò)分析工具(如Wireshark或Prometheus)診斷瓶頸,優(yōu)化數(shù)據(jù)傳輸和計(jì)算負(fù)載。這可能包括調(diào)整網(wǎng)絡(luò)參數(shù)、實(shí)施緩存策略或采用邊緣計(jì)算以減少延遲。

- 安全與合規(guī)服務(wù):提供端到端加密、訪問(wèn)控制和漏洞掃描,確保模型和數(shù)據(jù)在網(wǎng)絡(luò)傳輸中的安全。協(xié)助滿足GDPR、HIPAA等法規(guī)要求。

- 可擴(kuò)展性支持:隨著模型規(guī)模擴(kuò)大,網(wǎng)絡(luò)技術(shù)服務(wù)可幫助擴(kuò)展集群規(guī)模,采用微服務(wù)架構(gòu)或serverless計(jì)算,實(shí)現(xiàn)彈性資源分配。

三、實(shí)踐建議與未來(lái)展望

在搭建AI大模型網(wǎng)絡(luò)時(shí),建議從小規(guī)模原型開(kāi)始,逐步測(cè)試網(wǎng)絡(luò)性能。與專(zhuān)業(yè)網(wǎng)絡(luò)服務(wù)提供商合作可加速部署,例如利用云計(jì)算平臺(tái)的托管服務(wù)(如Google AI Platform或Azure Machine Learning)。隨著5G和6G技術(shù)的發(fā)展,AI大模型網(wǎng)絡(luò)將更加高效,網(wǎng)絡(luò)技術(shù)服務(wù)也將融入更多AI驅(qū)動(dòng)的自動(dòng)化工具,實(shí)現(xiàn)智能運(yùn)維。

AI大模型網(wǎng)絡(luò)搭建是一個(gè)多學(xué)科集成的過(guò)程,而網(wǎng)絡(luò)技術(shù)服務(wù)則保障了其可靠性和可擴(kuò)展性。通過(guò)合理規(guī)劃和持續(xù)優(yōu)化,企業(yè)和研究機(jī)構(gòu)可以充分發(fā)揮AI大模型的潛力,推動(dòng)數(shù)字化轉(zhuǎn)型。